BenchLLM — это специализированный инструмент для оценки качества LLM-моделей и приложений на их основе. Сервис помогает разработчикам и ML-командам быстро понимать, насколько хорошо работает их ИИ в реальных сценариях, без сложной ручной настройки и разрозненных скриптов.

Оценка LLM «на лету»

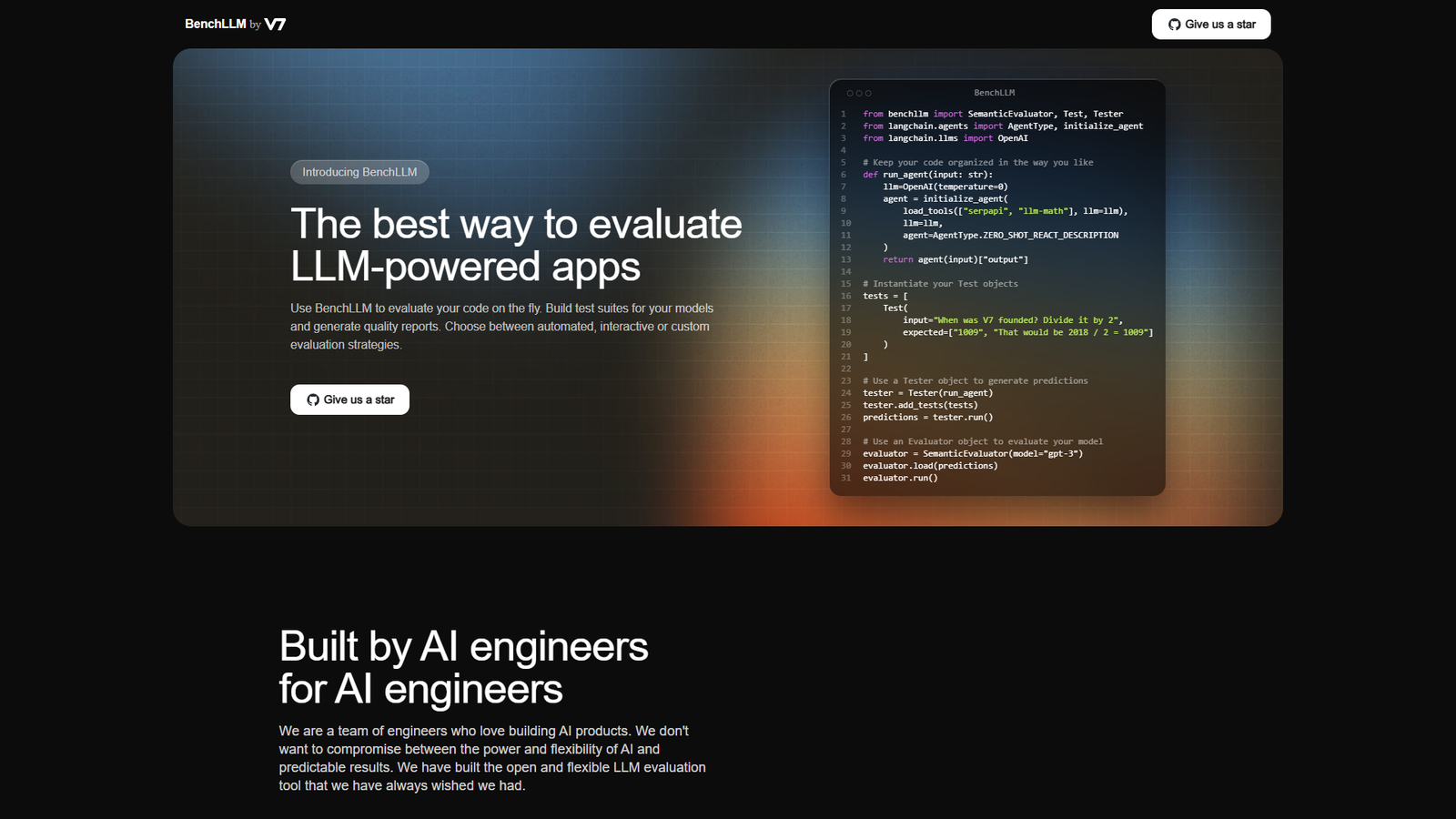

BenchLLM позволяет запускать проверки прямо из кода: создавайте тестовые наборы, сравнивайте ответы моделей и получайте структурированные отчёты о качестве. Поддерживаются как автоматические проверки, так и интерактивные сценарии с участием человека.

Гибкие стратегии тестирования

Платформа предлагает три подхода к оценке: автоматизированный, интерактивный и полностью кастомный. Вы можете комбинировать метрики, семантическую оценку, ручной ревью и свои собственные правила, чтобы точнее измерять релевантность, точность и стабильность ответов модели.

Интеграция с вашим стеком

BenchLLM легко встраивается в существующий код, пайплайны и CI/CD. Используйте готовые классы вроде SemanticEvaluator, Test и Tester, интегрируйтесь с LangChain и другими фреймворками, чтобы сделать проверку LLM-приложений такой же привычной, как юнит-тесты для обычного кода.