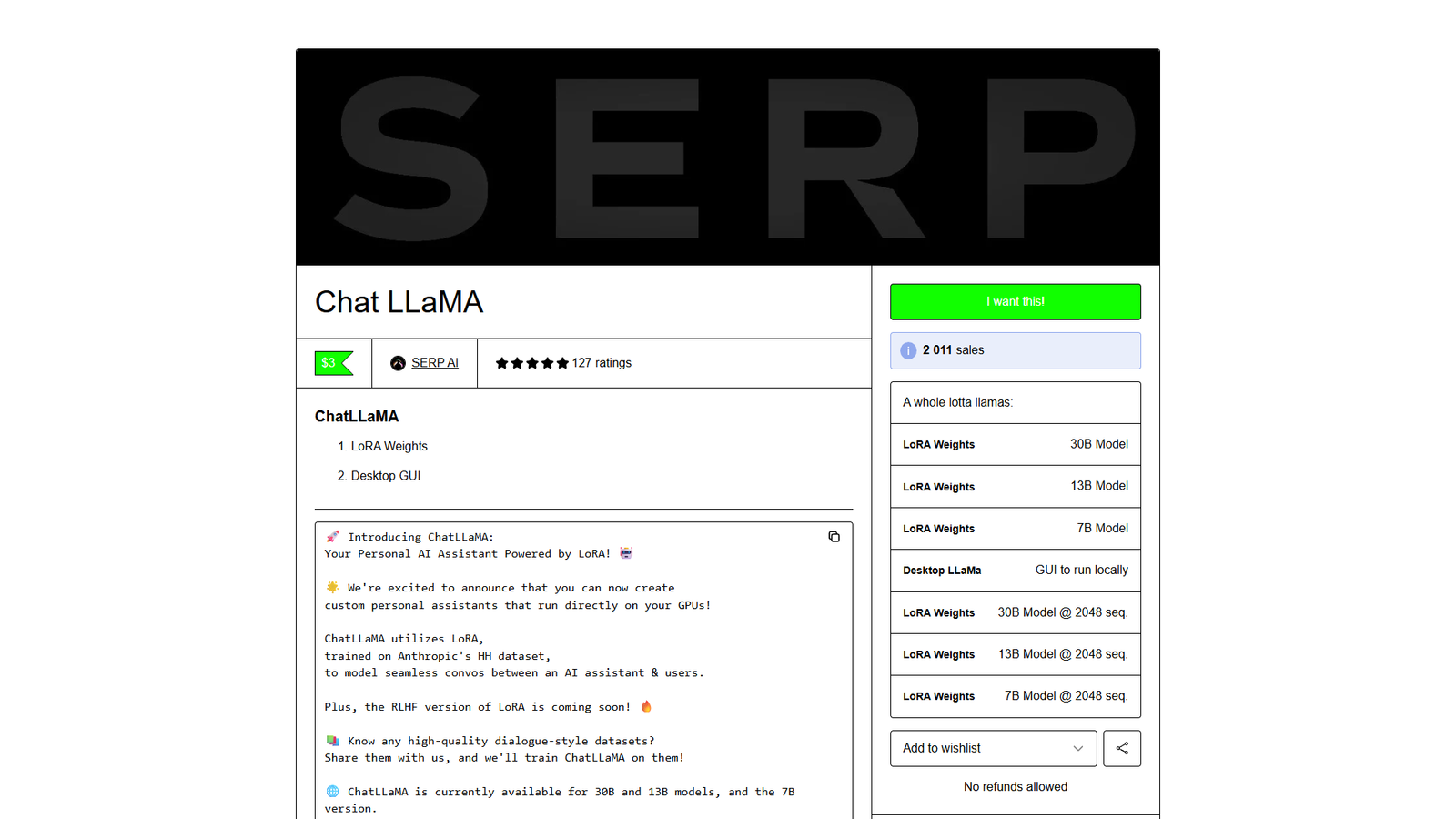

Chat LLaMA — набор LoRA-весов и desktop GUI для создания персональных AI‑ассистентов на базе LLaMA, которые запускаются локально на вашей GPU. Проект ориентирован на исследовательские и практические сценарии, где важны приватность, контроль над моделью и возможность кастомизации.

Персональный ассистент на вашей видеокарте

Сервис предлагает LoRA-адаптации, обученные на диалоговом датасете Anthropic HH, чтобы получать более «ассистентный» стиль общения и устойчивые ответы в формате диалога. Доступны варианты под разные размеры моделей (7B/13B/30B), что помогает подобрать баланс между качеством и требованиями к железу.

Кастомизация и развитие

Chat LLaMA позиционируется как база для сборки собственных ассистентов: можно экспериментировать с датасетами, дообучением и настройками. Также заявлено, что версия LoRA с RLHF находится в разработке, а сообщество приглашает делиться качественными диалоговыми наборами данных и получать помощь в настройке через Discord.

Важно

Фундаментальные веса модели не распространяются; материалы предназначены для исследований.