Friendli Inference — это высокопроизводительный движок для сервинга больших языковых моделей (LLM), созданный для максимально быстрого и экономичного инференса. Платформа позволяет запускать генеративные модели с высокой пропускной способностью и минимальной задержкой, существенно снижая нагрузку на инфраструктуру.

Оптимизированный инференс LLM

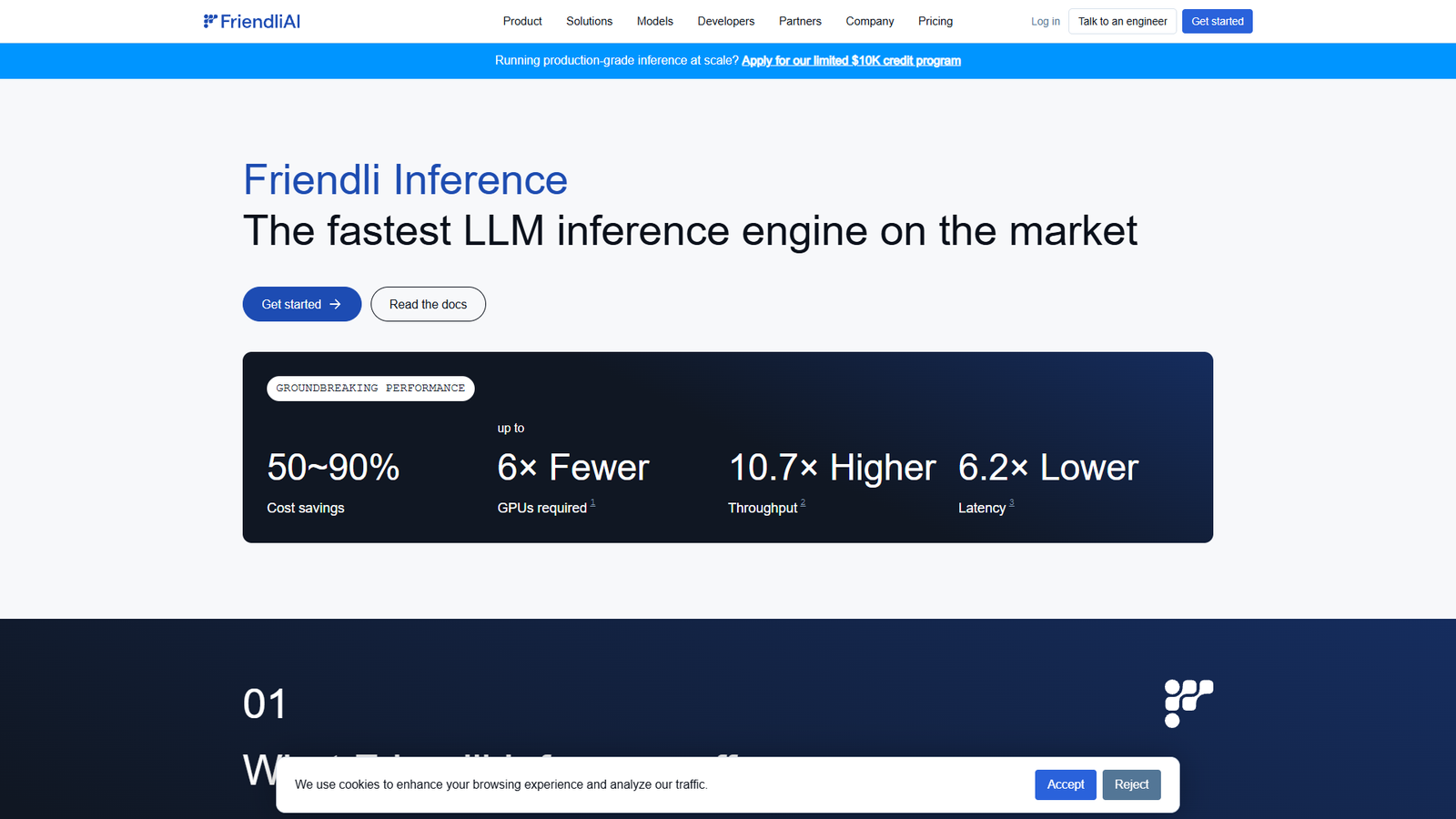

Friendli Inference использует специализированные оптимизации, которые обеспечивают до 50–90 % экономии затрат на GPU и требуют до 6 раз меньше видеокарт по сравнению с традиционными решениями. По результатам тестов сервис демонстрирует значительно более высокую производительность, чем vLLM и TensorRT-LLM, обеспечивая до 10,7× больший throughput и до 6,2× меньшую латентность.

Для разработчиков и продакшн-нагрузок

Решение ориентировано на команды, которым важно стабильно и дешево обслуживать LLM в продакшне: от стартапов до крупных компаний. Friendli Inference легко интегрируется через API, масштабируется под рост трафика и помогает выжать максимум из существующих GPU-ресурсов, не жертвуя качеством и скоростью генерации.