UpTrain — инфраструктура для команд, которые запускают и масштабируют продукты на базе больших языковых моделей. Инструменты фокусируются на оценке качества, мониторинге и систематическом улучшении LLM-приложений в проде.

Оценка и эксперименты с LLM

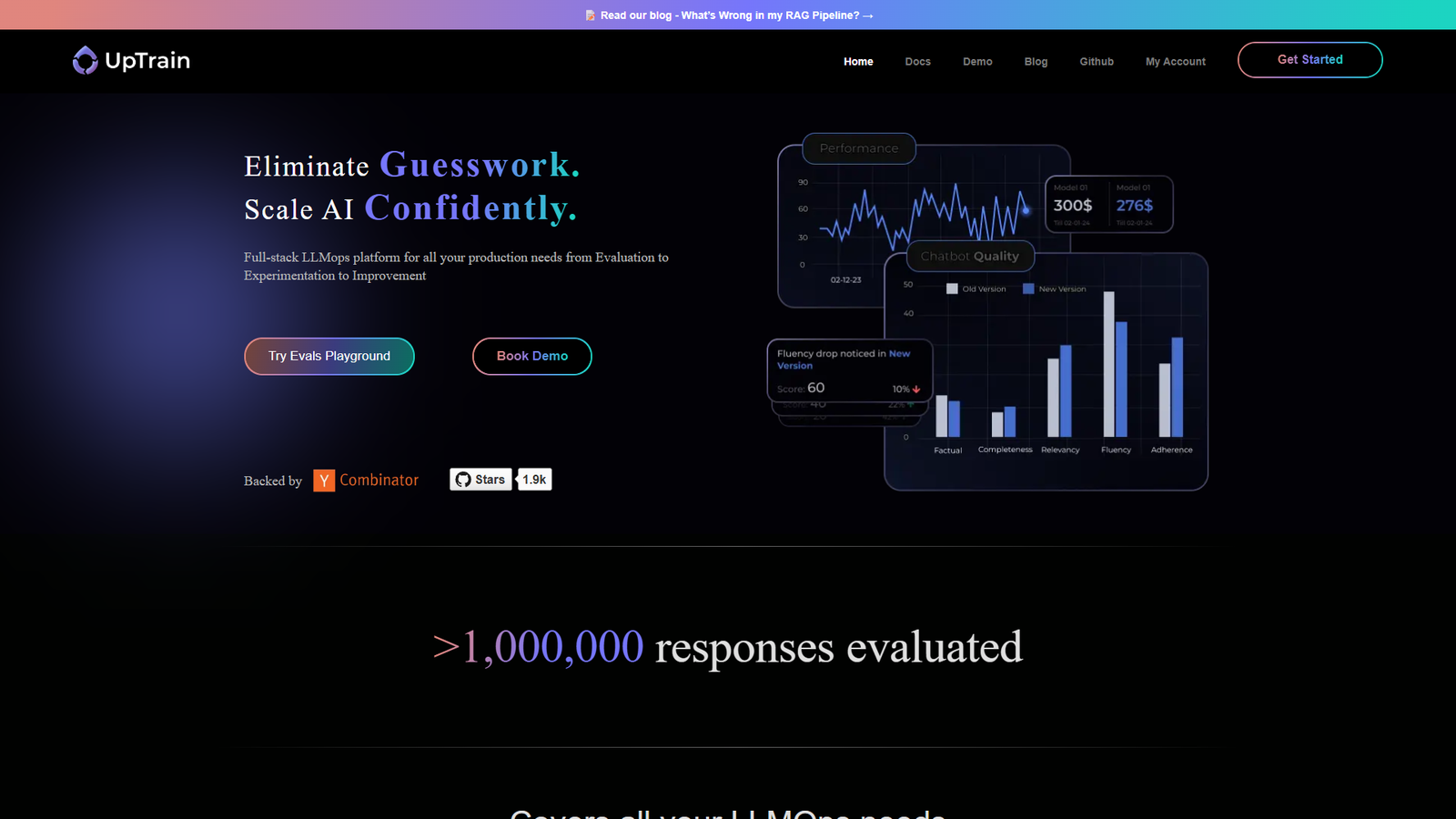

В UpTrain можно настраивать метрики качества ответов, сравнивать разные промты и модели, запускать A/B‑эксперименты. Разработчики проверяют точность, устойчивость к ошибкам и регрессии, а также отслеживают, как изменения в цепочках запросов влияют на итоговый результат.

Наблюдаемость и контроль в продакшене

Система собирает логи запросов и ответов, строит дашборды, помогает замечать деградацию качества и аномалии. Команды видят, как ведет себя LLM-приложение под реальной нагрузкой, и быстрее находят проблемные сценарии.

Интеграция в существующую инфраструктуру

UpTrain подключается к уже работающим LLM-сервисам через API и встраивается в пайплайны разработки. Есть варианты развертывания в собственном защищенном облаке, что важно для корпоративных данных и требований безопасности.

Улучшение моделей по циклу

Собранные логи и оценки используются для итеративного улучшения промтов и конфигураций моделей. Команды строят замкнутый цикл: наблюдение, анализ, эксперимент, обновление, что снижает долю ручных догадок и делает работу с LLM более предсказуемой.